每十年性能增长约1000倍,这是HPC(高性能计算)领域的“千倍定律”,背后则是计算力对于AI、大数据等新兴工作负载的不断满足,作为GPU领域的领导企业,英伟达也在深耕多年后迎来了收获:在TOP500位列榜首的超算系统Summit中,英伟达GPU提供了95%计算力。然而,英伟达要做的并不止是“计算力提供商”,而是要将基于GPU的领导力扩展到更广阔的多样化计算和云生态,以打造人工智能时代的现代化基础设施。在SC19上,NVIDIA创始人兼首席执行官黄仁勋发布了用于构建GPU加速Arm服务器的参考设计,并且宣布微软在Microsoft Azure上部署了NDv2超大型实例,这被认为是“全球最大的GPU加速的云端超级计算机”。同时,英伟达还推出了NVIDIA Magnum IO软件套件,帮助数据科学家及AI和高性能计算研究者解决数据瓶颈问题。

NVIDIA创始人兼首席执行官黄仁勋

“高性能计算领域正在同时朝各个方向扩展,实际上高性能计算已无处不在,比如超级计算中心、云和边缘等等。”在黄仁勋看来,HPC市场的变化充斥在各个方面:基于大量传感器阵列的高性能流式计算、使用边缘计算进行更复杂的筛选、在云端运行高性能计算、使用AI加速高性能计算等等。其中,HPC与AI相互促进的融合发展堪称近年来的一大亮点。上个月,黄仁勋宣布NVIDIA正在与Ericsson、微软、Red Hat等公司合作,利用NVIDIA EGX边缘超级计算平台为企业和5G电信网络边缘AI提供支持。本月初,美国邮政署宣布将采用NVIDIA的端到端AI技术,其每天要处理近5亿封邮件。目前,首批AI超级计算机已经推动了聚变能、引力波等多个领域的科学研究。

值得一提的是,黄仁勋在演讲环节还在现场展示了全球最大的交互式立体可视化项目——与NASA一起模拟火星着陆。该模拟的内容是让一个体积大小约为一栋双层公寓、且正在以时速12000英里的速度飞行着的飞行器在七分钟内安全地停下,然后着陆。据了解,该模拟以随机存取的方式传输150 TB数据,数据量相当于12.5万张DVD的数据存储量之和。为此,英伟达还在超级计算机旁配备了一台超级计算分析仪器。

约1400名研究者和技术人员在现场聆听了NVIDIA的主题演讲

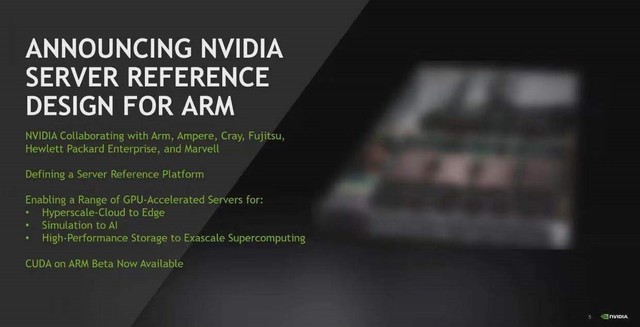

加速Arm生态超算构建

Arm正在成为HPC领域的新选择,此前日本就曾透露下一代Kyo HPC的处理器会从SPARC64架构全面转向Arm架构,这是Arm在E级超算时代的一次尝试。而其制造商富士通也研发出了采用512bit浮点运算单元的ARMv8 SVE芯片。与此同时,基于Arm架构的计算设备也超过千亿台。或许是看到了这一趋势,英伟达在年初为Arm带来了CUDA-X软件平台。在SC19上,英伟达发布的参考设计平台可以使企业能够快速构建GPU加速的Arm服务器,该平台由硬件和软件基础模块组成,英伟达将提供Arm兼容软件开发套件的预览版本,该版本包含NVIDIA CUDA-X库和加速计算开发工具。

为了构建这一参考平台,英伟达与Arm及其生态合作伙伴(Ampere、富士通、Marvell等)联手,以确保NVIDIA GPU与Arm处理器之间的无缝协作。该参考平台还得益于与HPE旗下公司Cray和HPE这两家早期采用Arm服务器的供应商之间的紧密合作。此外,很多高性能计算软件公司已使用NVIDIA CUDA-X库来构建可在Arm服务器上运行、并可通过GPU实现的管理和监控工具。这些合作伙伴包括GROMACS、LAMMPS、MILC、NAMD、Quantum Espresso、Relion等。

为了让Arm平台上的应用实现GPU加速,英伟达及其高性能计算应用生态合作伙伴还编译了大量代码。除了应用层面的合作,英伟达还与Canonical、Red Hat、SUSE强化了基础开发工具。正是有了如此广泛的生态,才推动了像美国橡树岭国家实验室和桑迪亚国家实验室、英国布里斯托大学、日本理化学研究所等机构或组织在GPU加速Arm计算系统上的测试和应用。目前,已启动并开始运行的应用已有30个。

“在HPE、Marvell和NVIDIA的帮助下,橡树岭国家实验室(Oak Ridge National Laboratory)成功完成了所负责的工作,迅速升级了Arm测试系统,整合性能测试并取得了良好的成果。短短两周内,我们编译并正确运行了约八个领先级应用程序,三个重要的社区库,以及常被用于评估Arm高性能计算生态的基准套件。”美国橡树岭国家实验室国家计算科学中心科学主任Jack C. Wells谈到,“对于Arm的加速计算生态而言,这是一个了不起的开始。”

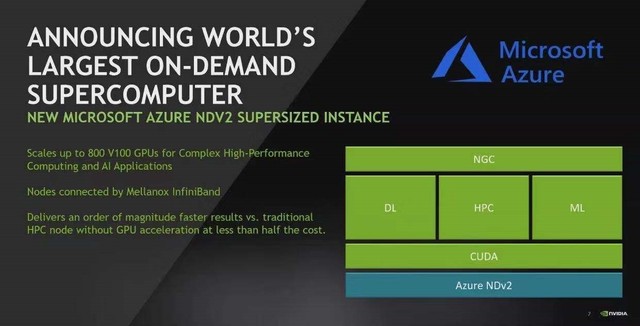

携手微软打造“最大规模云超算”

以云的方式将大规模AI训练或推理集群的资源共享出来,配合异构环境的基础设施、高性能软件栈,成为了当前的一大趋势,云计算业务也成为了英伟达新的增长动力,这种HPC“软件化”的方式促进了超算的普惠。就像黄仁勋在发布Microsoft Azure上的GPU超级计算机NDv2时所说的,“这让全球每一位科学家都拥有了一台超级计算机”,使用者只需打开实例、启动容器中的堆栈即可借助HPC来开展科学研究,这意味着研究人员可以按需租用整台AI超算,其功能与那些需要长达数月部署时间的大型本地超级计算机相匹配。

NVIDIA发布Microsoft Azure云端可扩展型GPU加速超级计算机

据了解,Azure NDv2实例专为处理要求苛刻的AI和高性能计算应用而设计,能够在一个Mellanox InfiniBand后端网络上提供800个互联的NVIDIA V100 Tensor Core GPU,相信这也是英伟达收购Mellanox后在组件互联上取得的新进展。对于想要快速构建AI解决方案的开发者来说,可以迅速启动多个Azure NDv2实例,在数小时内完成复杂的会话式AI模型训练。相比基于CPU的传统运算方式,具有显著的性能和成本优势,适用于复杂的AI、机器学习和高性能计算工作负载

此前,微软和NVIDIA的工程师已在该集群的预览版本上使用64个NDv2实例进行了实验。他们使用约三小时完成了BERT会话式AI模型的训练,实现这一速度的原因之一是使用了NCCL(一款NVIDIA CUDA X库)提供的多GPU优化,以及高速Mellanox互联解决方案。

另一个优势是,客户可以使用多个NDv2实例运行复杂的高性能计算工作负载。以LAMMPS为例,这是一种流行的分子动力学应用程序,用于在药物开发和探索等领域中模拟原子级物质。相较专用于特定应用程序(如深度学习)、未使用GPU的HPC计算节点,单个NDv2实例可实现一个数量级的速度提升。如果需要进行大规模的模拟,还可以将这一性能线性扩展至一百个实例。

此外,所有NDv2实例都能够受益于NVIDIA NGC容器注册表和Azure Marketplace所提供的TensorFlow、PyTorch和MxNet等GPU优化高性能计算应用、机器学习软件及深度学习框架。该注册表还提供Helm图表,使得用户在Kubernetes集群上轻松部署AI软件。目前,NDv2已推出预览版本,一个实例包含8个NVIDIA V100 GPU,可组成集群,根据不同的工作负载需求进行扩展。

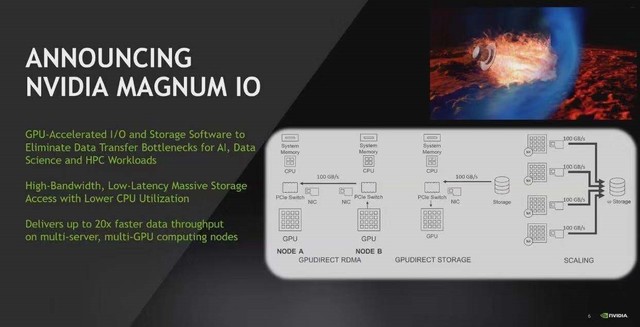

让数据驶上高速公路

如何让海量的数据在有限的核心区域快速交互,对存储部件的互联有着很高的要求,这也直接影响了系统的性能表现。为此,英伟达推出了NVIDIA Magnum IO软件套件,以帮助数据科学家,以及AI和高性能计算的研究者,可以在数分钟内处理好以往需要数小时才能处理完的海量数据。

Magnum IO专为解决存储和I/O瓶颈进行了优化,优化后在执行财务分析、气候建模等复杂、需要处理大量数据集的高性能计算工作负载时,多服务器、多GPU计算节点的数据处理速度较之前提升20倍。这一成绩的实现,与NVIDIA和DataDirect Networks、Excelero、IBM、Mellanox、WekaIO等网络或存储企业的合作密不可分。

作为Magnum IO的核心, GPUDirect Storage为数据提供了一条路径,该路径可以绕过CPU,在GPU、存储和网络设备所提供的“开放式高速公路”上进行传输,快速访问用于模拟、分析或可视化的数据文件。GPUDirect由点对点和RDMA组件组成,兼容多种通信互联产品与API,包括NVIDIA NVLink、NCCL、OpenMPI和UCX。目前,Magnum IO软件已经上市,GPUDirect Storage则仅为部分用户提供了早期访问权限,英伟达计划在2020年上半年向所有客户提供GPUDirect Storage。

DDN首席研究官Sven Oehme表示:“最新的HPC和AI研究依靠的是海量数据,其数据规模通常都超过PB级,因此需要更高级的领先技术才能最有效应对这一挑战。DDN使用NVIDIA的Magnum IO软件套件,以及我们的并行EXA5存储结构开辟了新的直接数据路径,使GPU在高带宽下可以直接访问PB级数据存储。这种方法在以前是不可能实现的。”

结语

在英伟达看来,高性能计算的下一步将会是使用大量软件定义传感器,将数据优先发送到可编程的边缘计算机,然后将其中最相关的数据发送到超级计算机,最终由超级计算机从海量的实时数据中获取洞察。要想在这些数据中获取价值,不仅需要数万个计算节点的智能超算,同样需要以多元化的方式扩展HPC的开发、部署、实践场景,只有这样才能迎来更为广阔的天地。而英伟达作为在算力服务领域的开拓者,也在不断将更多的技术创新融入用于HPC的GPU,希望以此在现代AI所处的全新计算时代寻求更大的突破。

本文属于原创文章,如若转载,请注明来源:SC19:发力Arm 携手Azure 英伟达踏上超算新征程//cloud.zol.com.cn/732/7328938.html