2025 年世界人工智能大会(WAIC)于 7 月 26 日至 29 日在上海世博展览馆盛大开展,全球领先的 AI Native Cloud 服务商 GMI Cloud 在此次大会上精彩亮相。作为全球六大 Reference Platform NVIDIA Cloud Partner 之一,GMI Cloud 携全栈产品矩阵、创新工具及前沿技术成果,在 H1 核心技术馆 A122 展位及 H4 FUTURE TECH 创新企业展区,通过产品展示、技术体验、专家分享、跨界互动等多元形式,与全球开发者、AI 企业及生态伙伴共探 AI 算力新未来,成为展会焦点之一。

在本次大会上,GMI Cloud 集中展示了三大核心产品,为观众打造了沉浸式的 AI 基础设施交互体验。GMI Cloud 作为一朵“AI Native Cloud”,凭借全球布局的数据中心与 NVIDIA 的深度合作,提供基于 H200、B200 等高端芯片的 GPU 云服务,融合灵活公有云与定制化私有云,能为企业量身打造安全高效的 AI 基础设施。此外,Cluster Engine 作为 GMI Cloud 自主研发的云管理系统,通过优化资源调度,提供了灵活且稳定的集群管理解决方案,让算力资源调配更加敏捷高效。Inference Engine 则是 GMI Cloud 全栈自研的推理引擎云平台,依托芯片级算子优化与动态负载调度,实现了 AI 推理性能倍增和弹性伸缩,为 AI 业务爆发提供了坚实支撑。

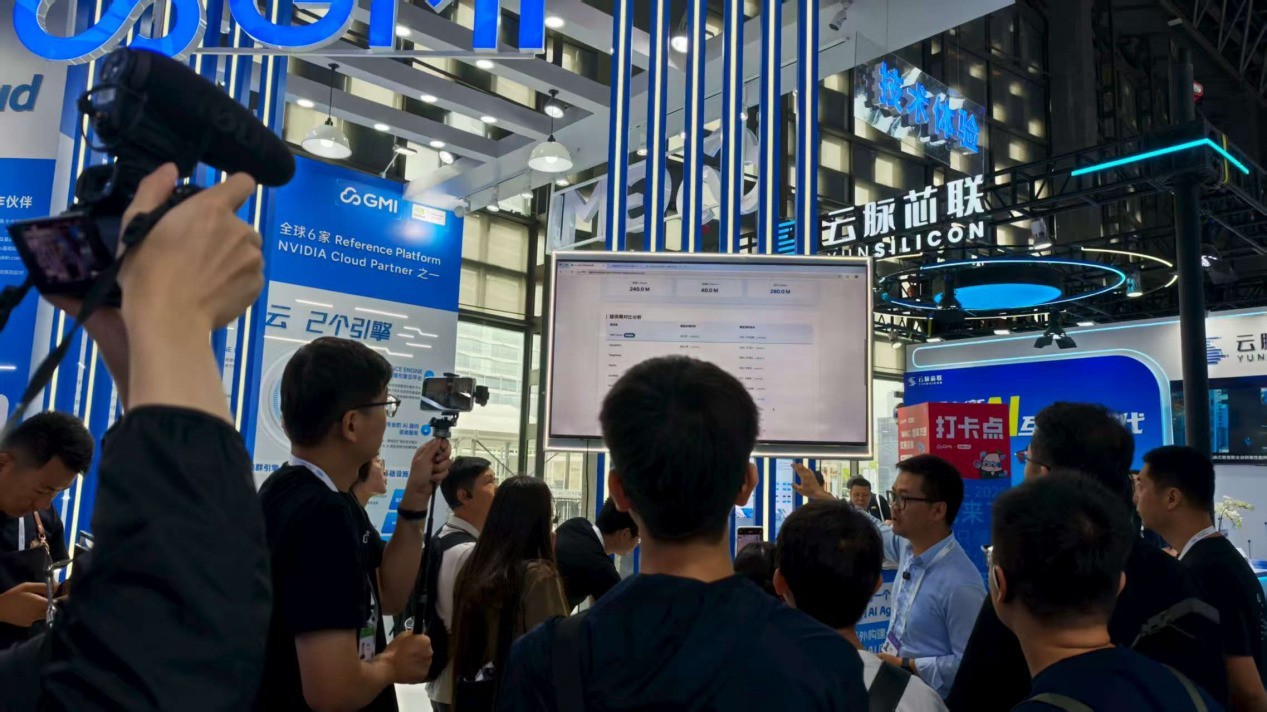

在本届 WAIC 上,GMI Cloud 展位特别设置的技术体验区人气高涨,其两大核心平台及工具直击 AI 应用构建痛点,让参会者亲身体验到 AI 应用构建的新可能。其中,刚上线的“AI 应用构建成本计算器”备受关注,开发者通过该工具,一键即可获取构建专属 AI Agent 或海外低成本 AI 应用的时间成本与经济成本测算结果,2 分钟内就能明晰投入方案,让全球 AI 应用开发规划更精准。另一大亮点是 Inference Engine 实战体验,参会者无需复杂流程,现场就能借助该引擎在平台上调用热门大模型 API,感受在海外快速落地 AI 想法的高效流程,其更高吞吐、更高稳定性的特点,让从创意到应用的转化更顺畅,助力开发者加速 AI 应用推向全球市场。

值得一提的是,GMI Cloud 的合作伙伴 DataDirect Networks (DDN) 也在其展位共同展出。DDN 是总部位于美国的存储及数据管理解决方案提供商,服务全球超 11,000 家企业客户,涵盖 AI 与数据分析等多个领域,其 A³I 存储系列、ES400X3 等产品广泛应用于大模型训练等场景。双方携手推出的联合 AI 基础设施解决方案,GMI Cloud 集成 DDN 高性能存储系统,具备动态可扩展性与可定制架构,为从模型训练到实时推理的严苛工作负载提供支撑,助力提升 AI 研发效率。

在跨界联动方面,GMI Cloud 与小红书携手推出的趣味打卡活动为展会注入别样活力,现场参与打卡互动的参会者可获得 WAIC 2025 专属拍立得照片,定格精彩瞬间。同时,GMI Cloud 技术 VP Yujing Qian 登上世博展览馆 H4 区域的小红书舞台,带来《混迹硅谷 10 年,AI 颠覆了我的 Coding 习惯》的即兴分享,结合自身在硅谷的十年技术研发经历,分享了 AI 技术如何重塑程序员的编码思维与工作方式,引发众多开发者共鸣。

在 36 氪×WAIC 2025 直播间,36 氪研究院院长邹萍与 GMI Cloud 亚太区总裁 King Cui 展开深度对话。据悉,36 氪研究院在 7 月 26 日发布的《2025 年中国 AI 应用出海企业发展需求洞察报告》中,大量引用了 GMI Cloud 在 AI 基础设施领域的技术优势和指导方案,包括其自研的 Cluster Engine 与 Inference Engine 在资源调度、推理性能优化等方面的突破性成果,以及全球数据中心网络支撑下的高效算力服务能力。基于这些洞察与实践,双方从技术赋能商业的视角,剖析了 AI 应用出海的市场现状、核心壁垒及商业变现路径,为行业提供了有技术支撑的市场分析,这场“技术实践+行业研究”的对话具备双重权威性,引发广泛关注。

在专家分享方面,GMI Cloud 的技术实力与行业洞察得到充分展现。7 月 27 日下午,亚太区总裁 King Cui 在世博展览馆 H4 区域的 FUTURE TECH 舞台围绕 Inference Engine 展开深度分享,拆解其高并发、低延迟、动态扩缩容能力如何支撑全球 AI 业务爆发,解析了自研推理平台的架构设计、跨区域合规部署及软硬协同优化实践,揭秘了推理成本与效率指数级提升的关键路径。

7 月 28 日上午,GMI Cloud 技术 VP Yujing Qian 则在 OpenTalk 区域聚焦《GMI Cloud Inference Engine 在全球范围内的大规模集群调度和优化》主题内容,深入拆解热门大模型推理优化架构逻辑与技术实践,详解基于开源 的 的 P/D 分离架构设计、性能变化及优化作用,探讨了 KVCache 池化策略如何通过访存优化提升推理效率。

GMI Cloud 由 Google X 的 AI 专家与硅谷精英共同创立,拥有遍布全球的数据中心,为企业 AI 应用提供最新、最优的 GPU 云服务,服务对象涵盖全球新创公司、研究机构和大型企业,致力于提供稳定安全、高效经济的 AI 云服务解决方案。依托高稳定性的技术架构、强大的 GPU 供应链以及丰富的 GPU 产品阵容,GMI Cloud 确保企业客户在高度数据安全与计算效能的基础上,高效低成本完成 AI 落地。通过自研“Cluster Engine”“Inference Engine”两大云引擎平台,GMI Cloud 完成了从算力原子化供给到业务级智算服务的全栈跃迁,全力构建下一代智能算力基座,作为推动通用人工智能(AGI)未来发展的重要力量,持续在 AI 基础设施领域引领创新。

此次 WAIC 2025 之行,GMI Cloud 充分展示了其在 AI 基础设施领域的硬实力,通过与全球行业伙伴的深入交流与互动,进一步巩固了其行业地位。未来,GMI Cloud 将继续深耕 AI 基建领域,为全球 AI 发展贡献更多力量。

本文属于原创文章,如若转载,请注明来源:WAIC 2025上GMI Cloud展现AI基建硬实力,破解出海商业化难题https://cloud.zol.com.cn/1021/10219846.html